必赢学子在机器学习领域顶级会议NeurIPS上发表论文

(通讯员 段志斌 丁宇轩 王东)近日,72886必赢欢迎光临有5项成果被第37届神经信息处理系统大会(Conference on Neural Information Processing Systems,NeurIPS)成功录用,其中陈渤教授指导,博士生徐逸石与孙剑桥合作完成的《Context-guided Embedding Adaptation for Effective Topic Modeling in Low-Resource Regimes》、博士生王东升主导完成的《Tuning Multi-mode Token-level Prompt Alignment across Modalities》和博士生段志斌带领本科生吕帜一完成的《Few-shot Generation via Recalling the Episodic-Semantic Memory like Human Being》;田春娜教授指导,博士生丁宇轩完成的《The CLIP Model is Secretly an lmage-to-Prompt Converter》;值得一提的是学院2020级本科生郑皓天为第一作者完成的论文《Out-of-distribution Detection Learning with Unreliable Out-of-distribution Sources》入围Poster部分。

NeurIPS会议作为公认的人工智能、机器学习领域的国际顶级会议,也是中国计算机学会(CCF)推荐的A类会议,具有广泛而深远的国际影响力,受到业界的广泛关注。本届会议共有12343篇有效论文投稿,录用率为26.1%。

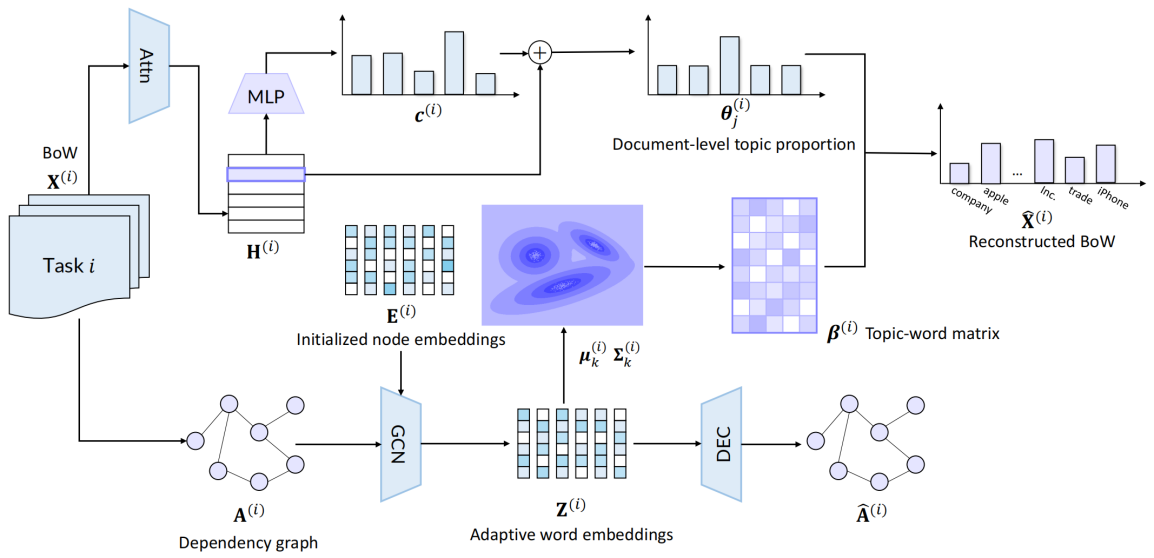

徐逸石与孙剑桥合作的《Context-guided Embedding Adaptation for Effective Topic Modeling in Low-Resource Regimes》延续了团队在认知深度概率模型的系列工作,该文针对资源不足条件下的主题建模提出了一种融合语境知识的框架。该框架的核心思想是通过整合当前任务的上下文信息来帮助生成自适应的词嵌入,其整体流程图如下图所示。具体而言,通过引入一个变分图自编码器对基于任务文档的语境提炼出的语法依赖图进行编码,可以学习到语义匹配当前任务的词嵌入。然后利用高斯混合模型对分布式的词嵌入进行建模,将每个混合分量视为一个主题的表示,该方法很自然地提供了一种聚类的视角来学习主题,这有助于尽可能地发现多样化的并且与当前任务紧密相关的主题。

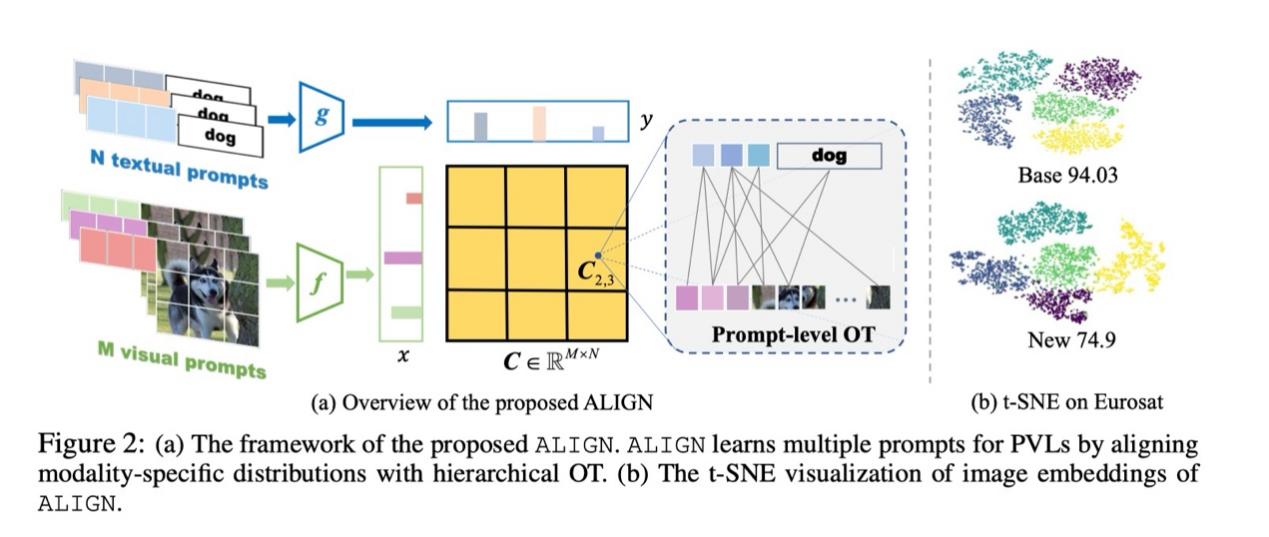

王东升的论文《Tuning Multi-mode Token-level Prompt Alignment across Modalities》探索形成了一种用于多模态提示学习的新范式,并提出一种新颖的token级别的模态对齐方法。文章将图像及其标签建模为隐空间的离散分布,同时考虑层次化的表示学习,通过引入全局和局部最优传输理论实现图像-文本模态对齐,然后可视化展示学到的转移矩阵,文章直观地展示了模型学习的对齐关系。大量实验结果证明所提方法在多种任务场景下达到了sota结果。

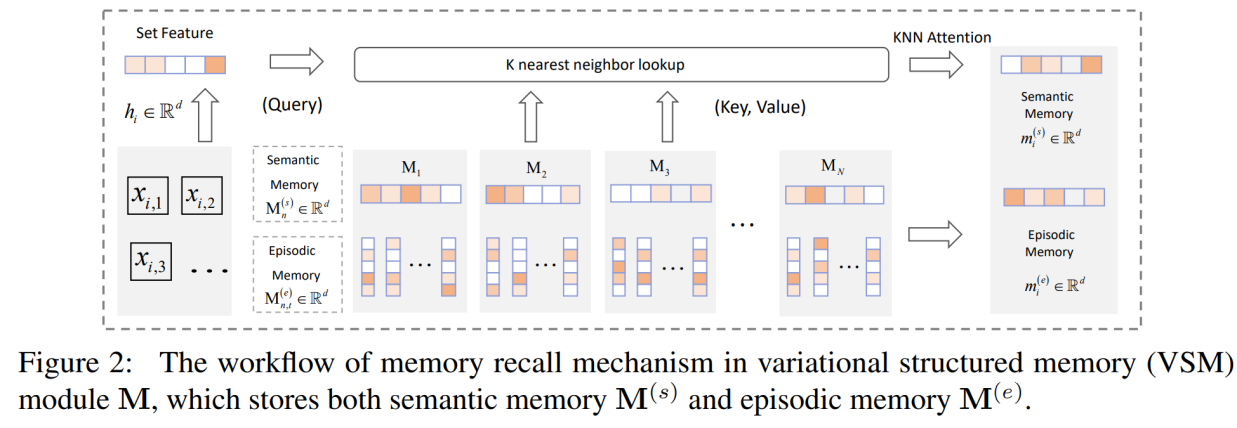

段志斌和吕帜一合作完成的论文《Few-shot Generation via Recalling Brain Inspired Episodic-Semantic Memory》面向小样本生成这一具有挑战性的任务,受大脑记忆力机制的启发提出了一种新颖的记忆力模块。该记忆力模块将情景记忆与语义记忆巧妙结合,其中情景记忆用于记忆具体的信息,语义记忆用于记忆抽象的信息。同时,文章中提出了一种情景记忆与语义记忆耦合的记忆力模块更新机制。所提出的记忆力模块被应用于层次化变分自编码器和概率扩散模型中,并取得了更好的小样本生成性能。下一步,课题组将继续深入研究将所提记忆力模块用于其他任务特别是小样本场景任务中。

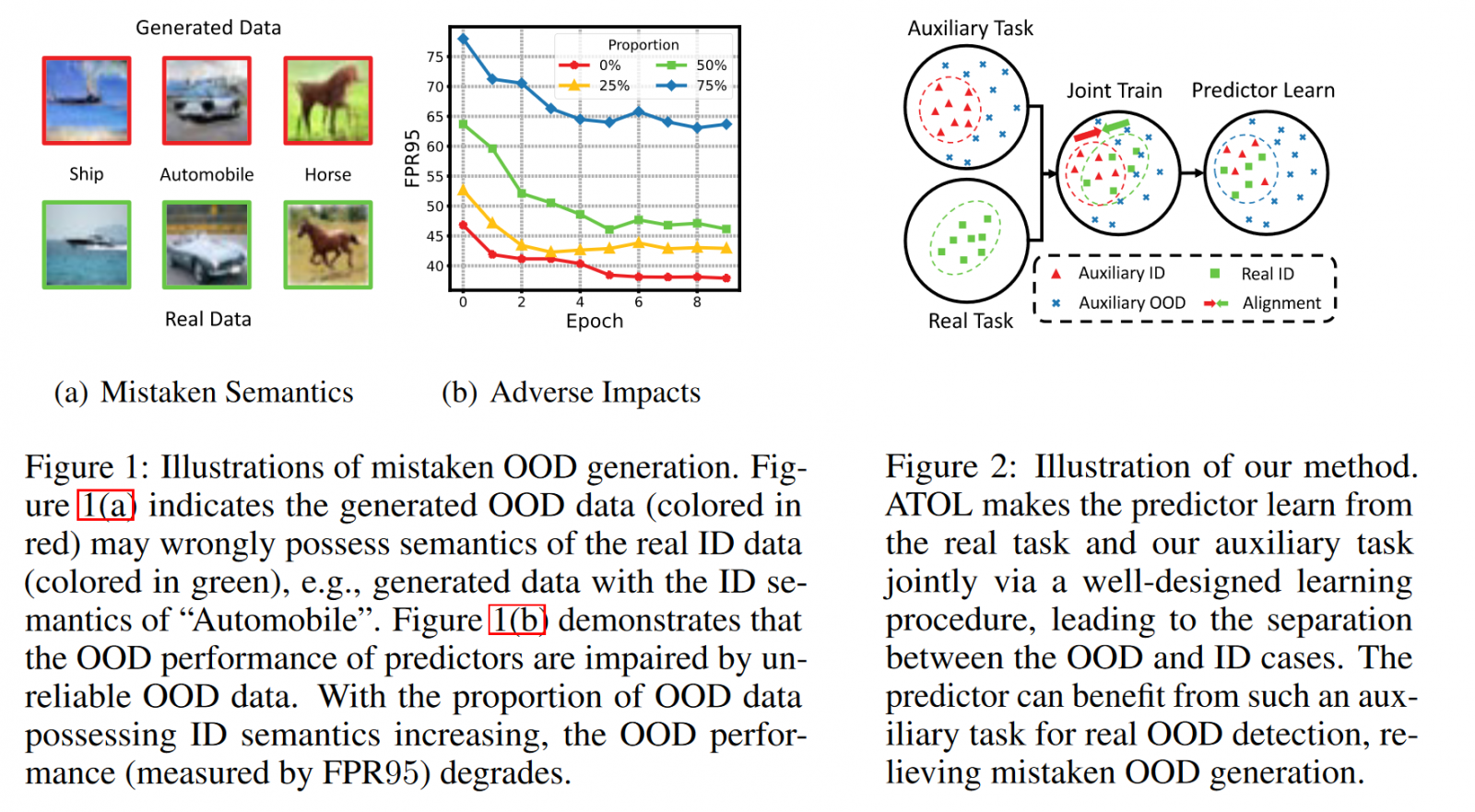

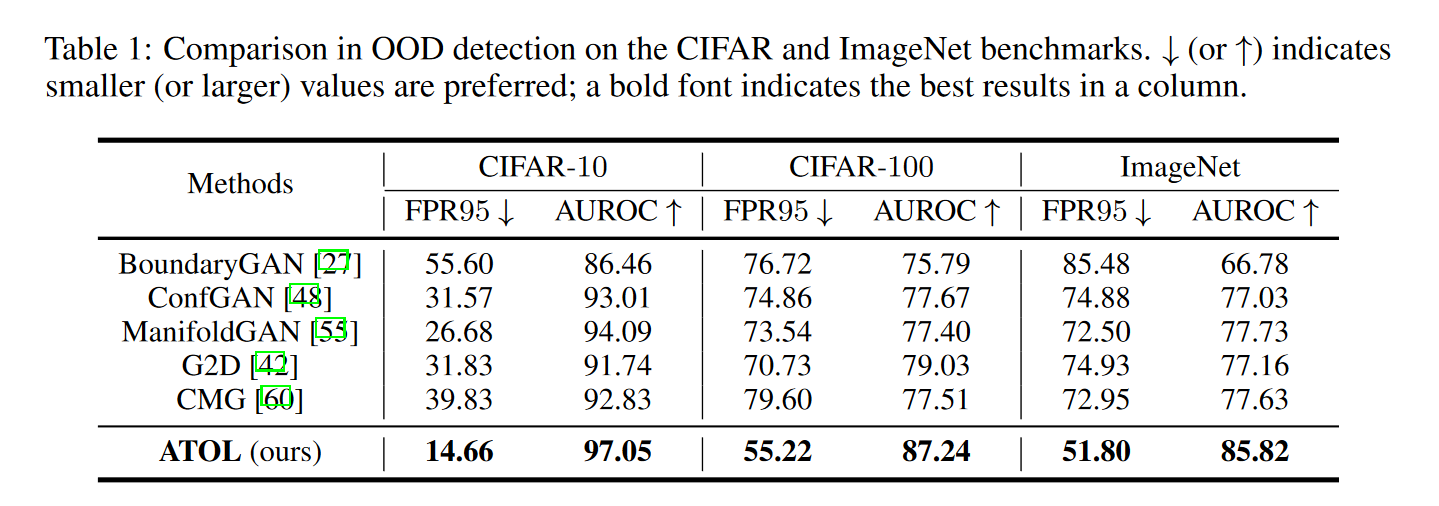

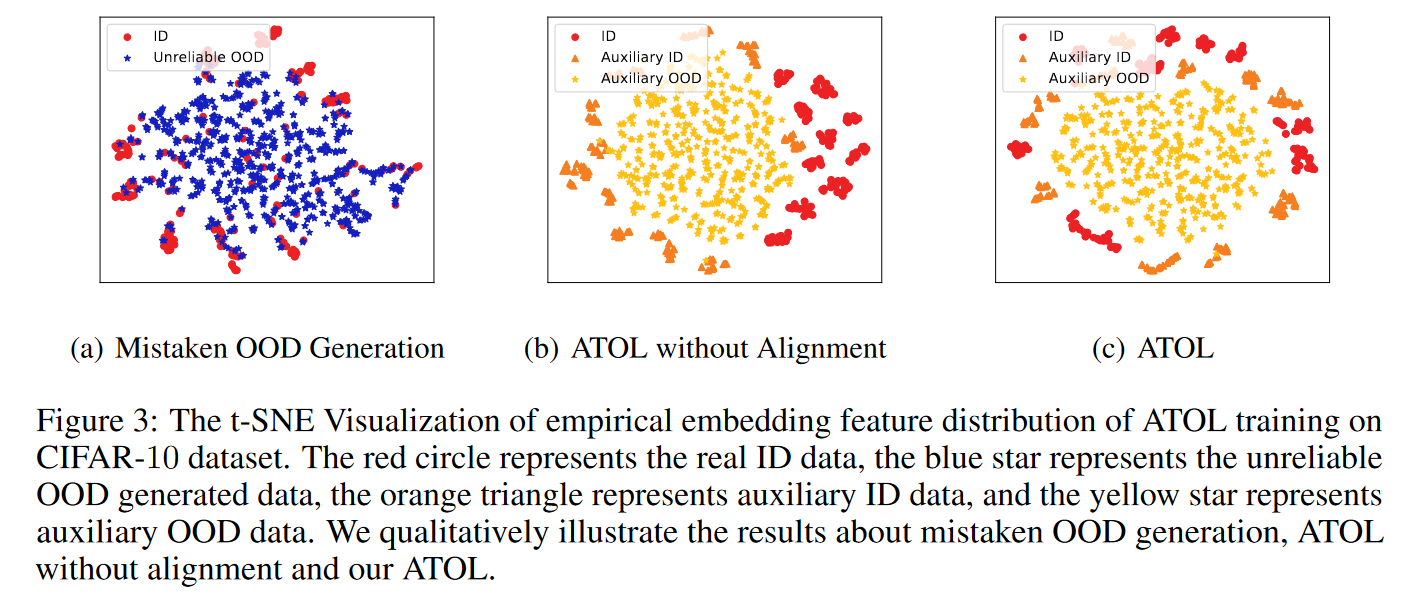

郑皓天的论文《Out-of-distribution Detection Learning with Unreliable Out-of-distribution Sources》创造性地提出了一个分布外学习框架ATOL,简单引入了一个生成的辅助任务,并与实际任务进行对齐训练,使得模型能高效学习到如何检测出分布外数据,大大提高了机器学习模型可信程度。

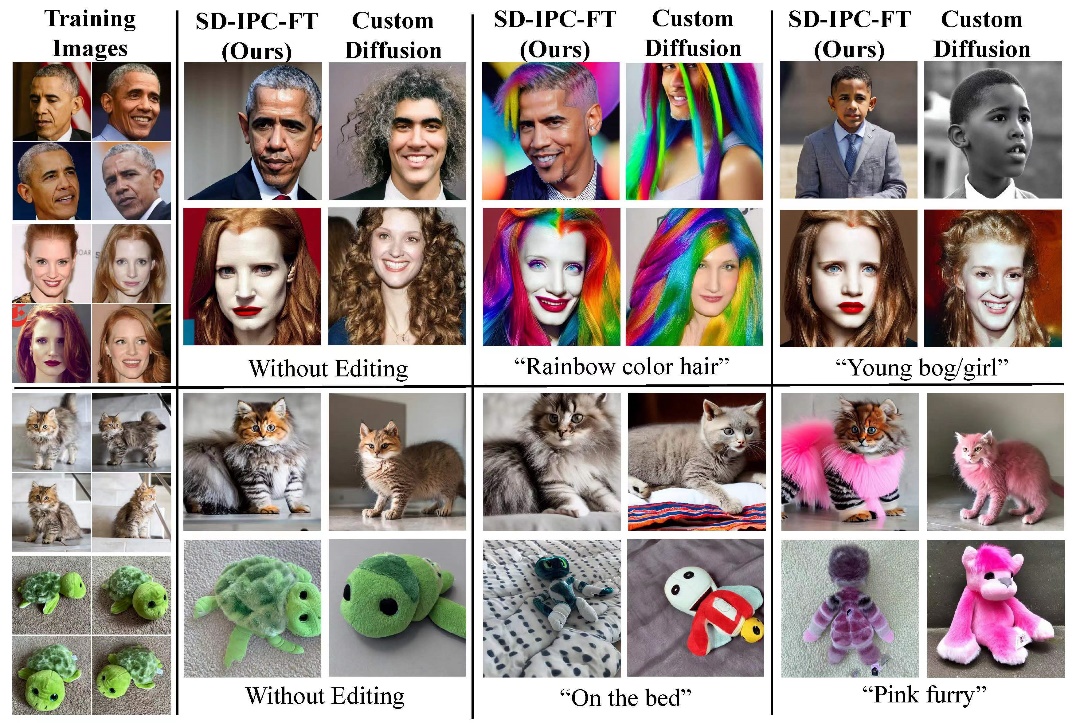

丁宇轩的论文《The CLIP Model is Secretly an Image-to-Prompt Converter》关注“文本到图像”生成模型StableDiffusion,通过对其特征空间的分析探究了模型生成原理,使用零成本闭式解实现了参考图像对输入文本的替换,将StableDiffusion模型转换为“图像到图像”生成模型,并拓展了其多模态输入能力(文本+图像)。相较于对比方法StableDiffusion-Reimagine,减少了20万GPU小时的训练时间,并提高了图像编辑效果。实验表明本文提出的闭式解可以作为模型微调的良好初始化,使用少量样本即可使模型关注不同的图像特征,并且可以在极少训练次数下完成定制图像生成任务。

一直以来,72886必赢欢迎光临面向国家重大需求,积极探索学生教育教学与实践创新相结合的人才培养模式,重视理论知识传授和科学素养培养,帮助学生养成自主学习能力、科技攻关能力、实践创新能力等,同时注重培养其家国情怀以及艰苦奋斗、科研报国的精神,引导学生在突破重大科学问题中坐住坐稳冷板凳,努力培育国家战略科技力量。